생성형 AI

생성형 AI는 데이터를 학습하여 새로운 정보나 콘텐츠를 생성하는 인공지능 기술입니다.

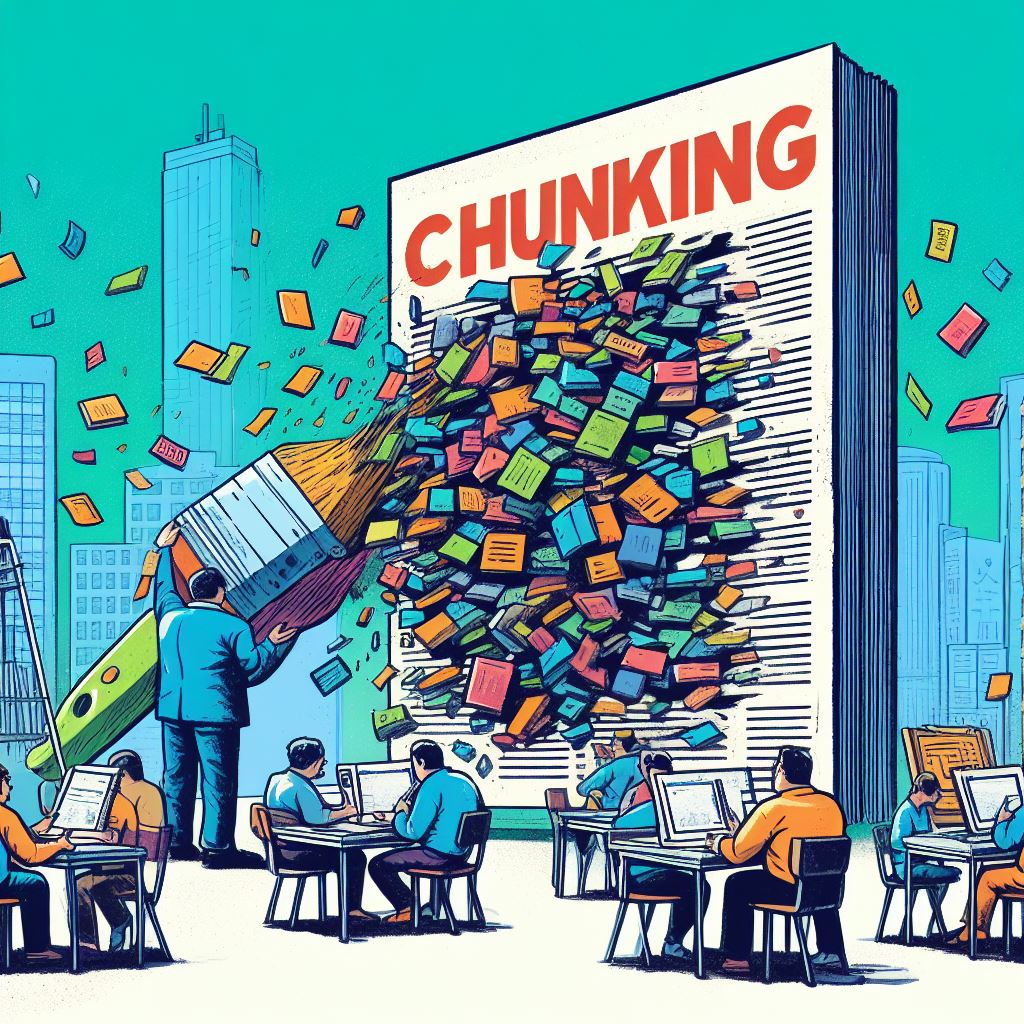

LLM 어플리케이션을 위한 Chunking Strategies

청킹은 텍스트를 작은 세그먼트로 나누는 과정으로, LLM 어플리케이션에서 중요한 최적화 기술입니다. 다양한 청킹 방법들이 있으며, 각 방법은 특정 상황에 적합할 수 있으며, 고정 크기 청킹, 재귀 청킹, 특수 청킹 등이 포함됩니다. 최적의 청킹 크기와 방법을 결정하려면 데이터 전처리, 청킹 크기 범위 선택, 그리고 각 청킹 크기의 성능 평가와 같은 여러 단계를 거쳐야 합니다.

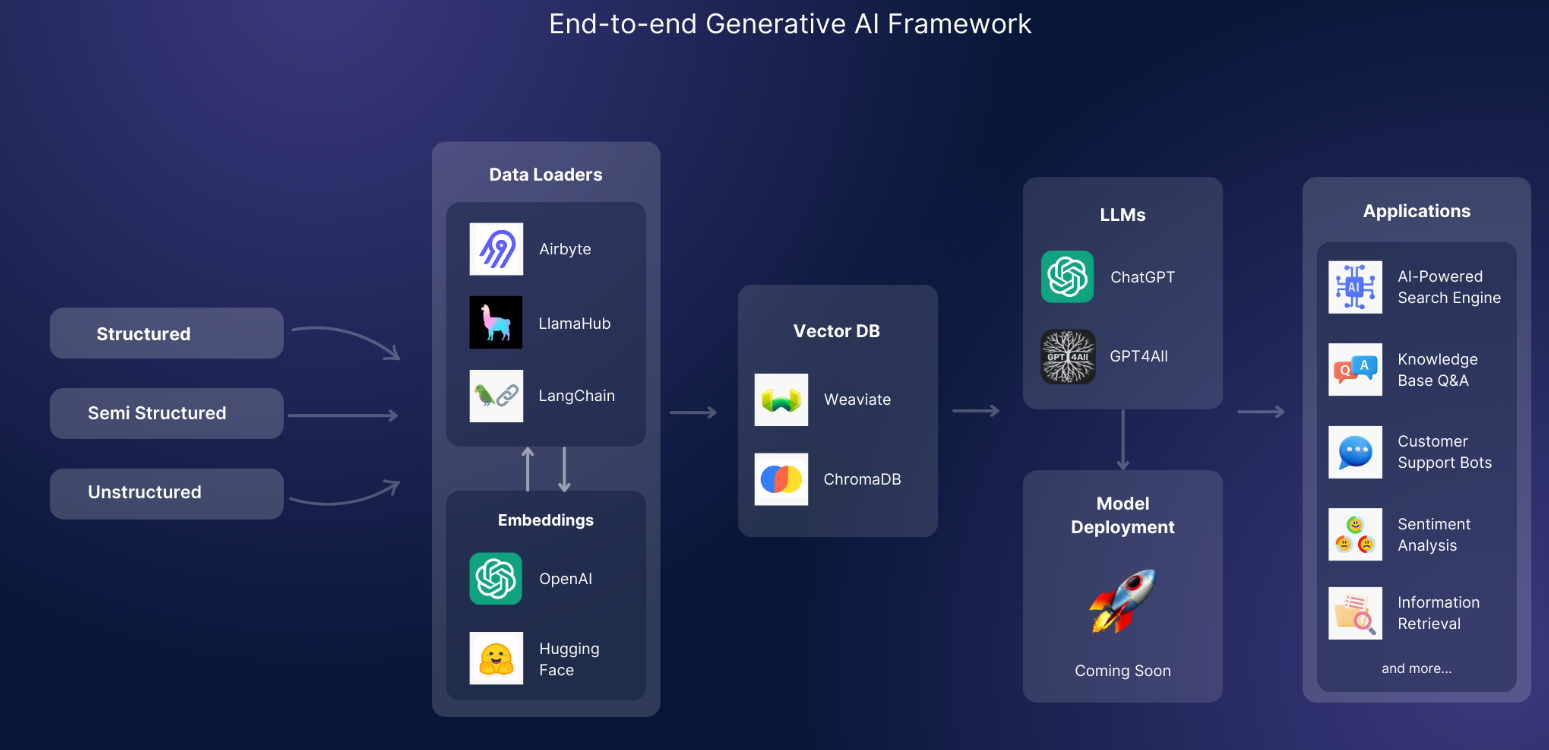

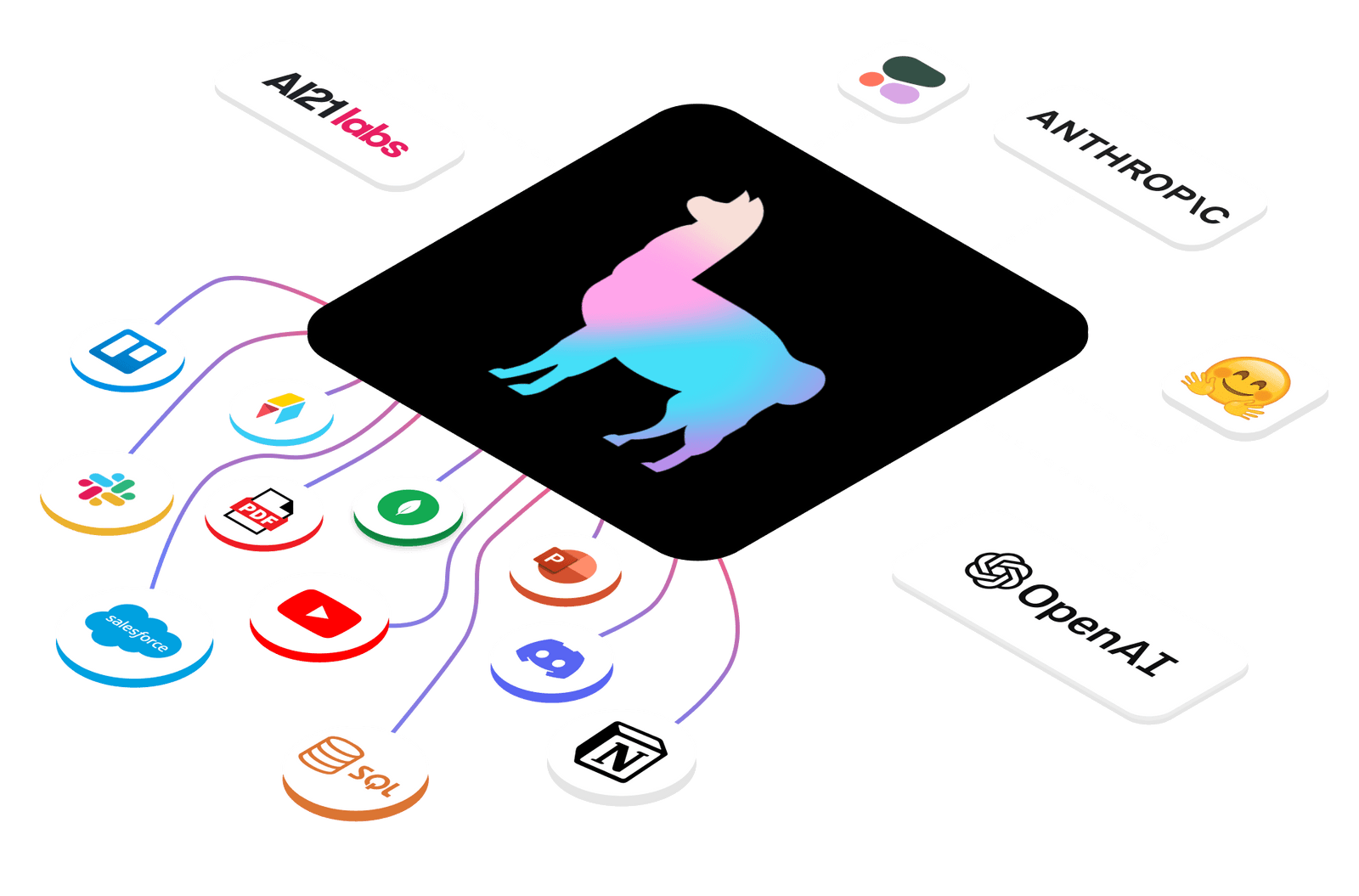

GenAI Stack의 다양한 활용성 및 기능

GenAI Stack은 대규모 언어 모델(Large Language Models, LLMs)을 애플리케이션에 통합하기 위한 엔드 투 엔드 프레임워크로, 데이터 처리의 복잡한 환경을 단순화하고, 환상 없는 AI 추론을 제공하여 실제 및 도메인 전문 지식에 기반한 출력을 보장합니다. 이 프레임워크는 AI 구동 검색 엔진, 지식 기반 Q&A, 감정 분석, 고객 지원 챗봇, 그리고 대량 문서의 정보 검색과 같은 다양한 사용 사례에서 활용할 수 있어, 개발자들이 AI의 잠재력을 효과적으로 활용하도록 돕습니다. GenAI Stack은 맞춤화와 제어를 제공하며, 기존 작업 흐름에 쉽게 통합하여 AI 개발 여정을 간소화하고 효율화합니다.

Hugging Face 플랫폼의 이해와 활용

이 플랫폼은 실시간 애플리케이션에서 인공 지능(AI)을 시연, 실행 및 배포할 수 있는 인프라를 제공합니다. 사용자들은 다른 사람들이 업로드한 모델과 데이터 세트를 찾아볼 수도 있습니다. Hugging Face는 개발자들이 자신의 작업을 공개적으로 공유하고 테스트할 수 있게 해주기 때문에 머신러닝의 GitHub로 종종 불립니다.

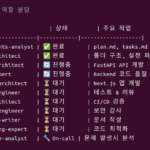

Microsoft AutoGen 활용하여 혁신적인 응용 프로그램 구축

AutoGen을 활용하면 실시간 데이터 분석 및 시각화 도구, 자동 고객 서비스 시스템, 협업 프로젝트 관리 도구, 자동 코드 생성 및 검토 시스템, 그리고 개인화된 학습 및 교육 플랫폼과 같은 다양한 응용 프로그램을 개발할 수 있습니다.

1201+ ChatGPT 프롬프트: 매출 향상을 위한 전환율 증가

구매자의 대략 60%가 챗봇과의 상호작용을 선호하며, 이를 통해 ChatGPT 판매 프롬프트가 매우 유용할 수 있습니다. 적절한 프롬프트를 제공함으로써, ChatGPT는 잠재 고객의 요구를 파악하고 충족시키는 데 도움을 줄 수 있으며, 이는 판매와 전환율 증가로 이어질 수 있습니다.

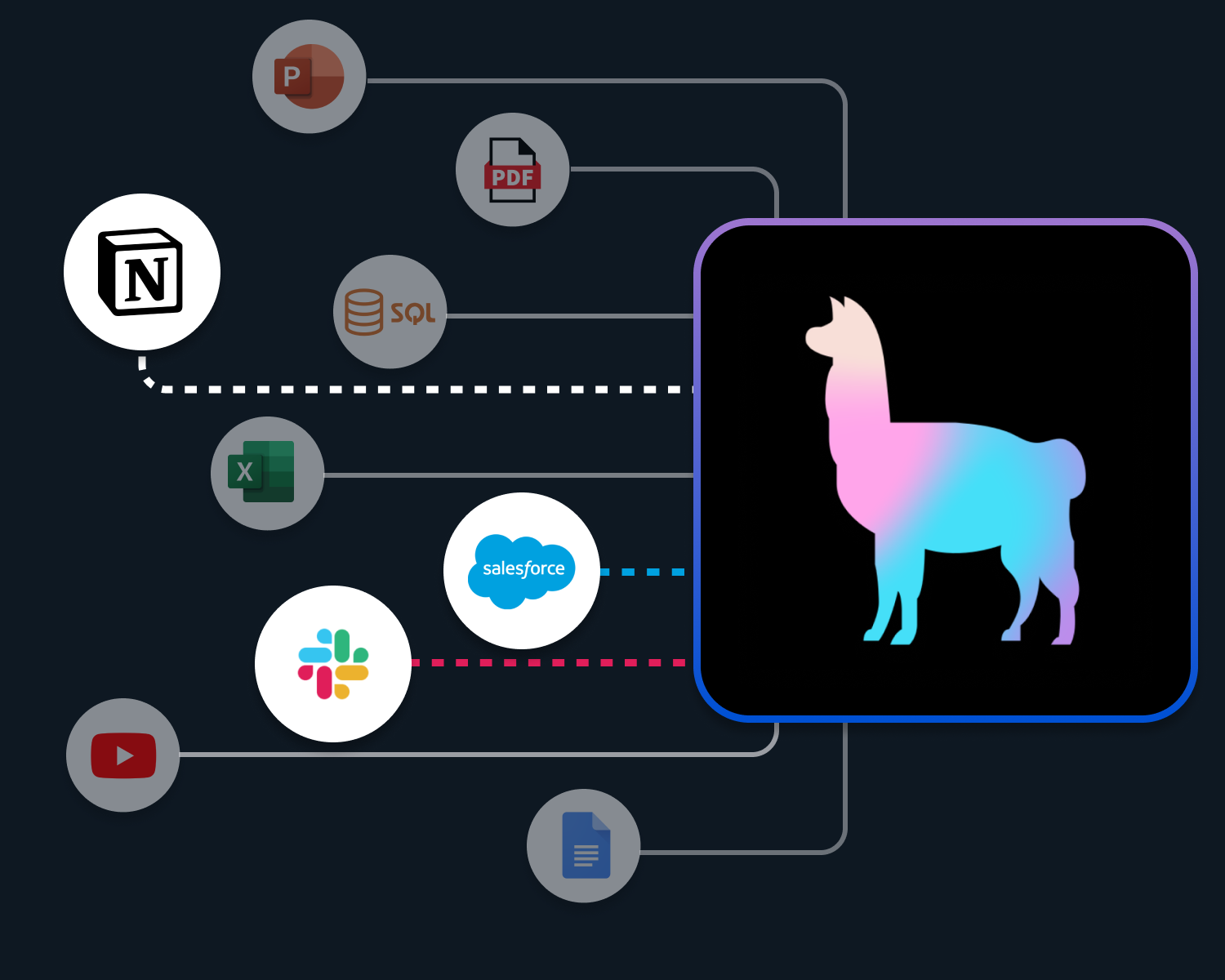

사용자 정의 데이터와 LLM의 결합: LlamaIndex의 고수준 개념 탐색

LlamaIndex는 다양한 데이터 소스와 포맷에서 데이터를 취득하고 구조화하여, 대규모 언어 모델(LLM) 기반의 응용 프로그램(예: Q&A, 챗봇, 에이전트)을 사용자 정의 데이터로 향상시키는 데 필요한 도구를 제공합니다. 이 프레임워크는 검색 증강 생성(RAG) 패러다임을 통해 사용자의 쿼리에 대한 응답을 생성하기 위해 쿼리 단계에서 관련 컨텍스트를 검색하고 LLM에 전달하는 데 중점을 둡니다. LlamaIndex는 검색기, 노드 포스트프로세서, 응답 합성기와 같은 구성 요소를 제공하여, 사용자가 쿼리 엔진, 채팅 엔진 또는 에이전트와 같은 다양한 RAG 파이프라인을 구축하고 통합할 수 있도록 지원합니다.

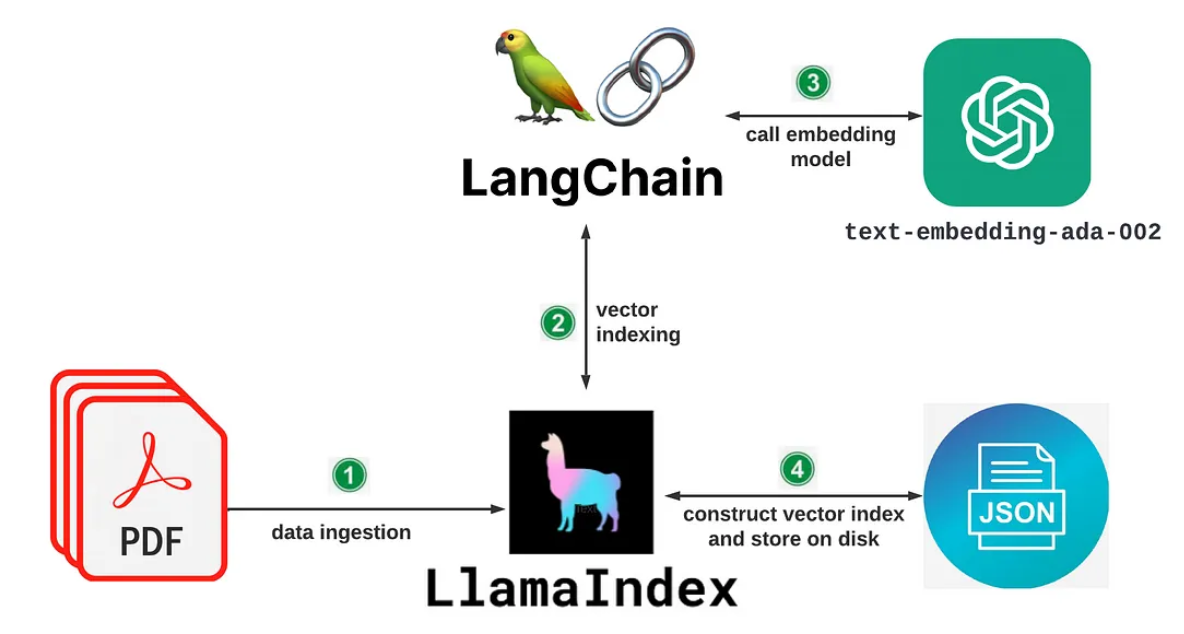

LlamaIndex 초보자 튜토리얼

LlamaIndex는 Llama 모델을 로컬 환경에서 실행하고 인덱스를 구축하여 텍스트 데이터를 쿼리할 수 있는 도구를 제공합니다. 사용자는 Python 스크립트 또는 Jupyter 노트북을 통해 문서를 인덱스화하고, 특정 키워드 또는 질문에 대한 쿼리를 실행하여 관련 정보를 검색할 수 있습니다. 또한, 사용자는 로깅을 설정하여 쿼리 및 이벤트를 확인하고, 인덱스를 디스크에 저장하거나 디스크에서 다시 로드할 수 있는 기능도 제공합니다.

자동 생성된 에이전트 채팅: 웹 정보가 필요한 작업 해결

AutoGen 프레임워크에서, AssistantAgent는 사용자의 요구 사항에 따라 Python 코드를 작성하는 역할을 하며, UserProxyAgent는 이 코드를 실행하는 프록시 역할을 합니다. 예를 들어, 사용자가 10대 기술 회사의 올해 수익 정보를 요청하면, AssistantAgent는 이 작업을 수행하기 위한 코드를 작성합니다. 그 후, UserProxyAgent는 이 코드를 실행하여 웹에서 필요한 정보를 획득하고 사용자에게 제공합니다.